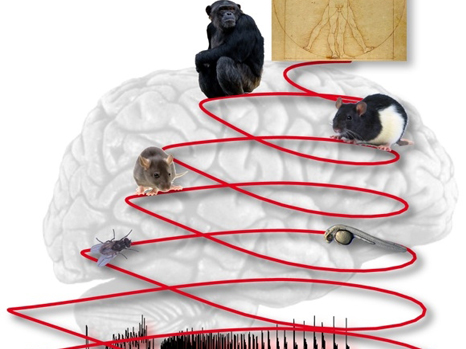

Chez les enfants autistes, les informations en provenance des 5 sens : du toucher, de l’ouïe, de la vision, ou d’autres stimuli, ne sont pas intégrées correctement dans le cerveau, conduisant à un comportement inapproprié et à des réactions parfois violentes. Des chercheurs de l’Inserm dirigé par Andréas Frick au sein de l’Unité Inserm 862 « Neurocentre Magendie » viennent de comprendre pourquoi en étudiant un modèle de souris mimant la maladie. Ils ont même trouvé une molécule pouvant inverser ces effets et rétablir un comportement « normal » chez ces souris.

Ces résultats sont publiés dans la revue Nature Neuroscience

Les troubles du spectre autistique (TSA) touchent plus de 3 millions de personnes dans l’union européenne dont environ 650 000 en France. Des estimations récentes du Centre pour le contrôle des maladies (aux Etats-Unis) suggèrent qu’un enfant sur 68 est touché par cette maladie. Les TSA sont des troubles neuro-développementaux qui affectent les enfants de toutes origines ethniques et socio-économiques, et sont caractérisés par un spectre de symptômes regroupant à la fois des difficultés pour les interactions sociales et la communication, et des comportements répétitifs stéréotypés.

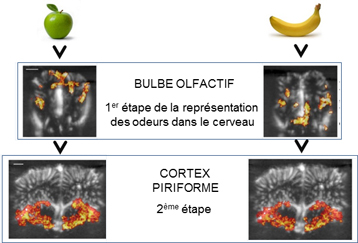

Un autre aspect fréquent des maladies neuro-développementales est le problème du traitement des informations sensorielles. Près de 90% des enfants avec des TSA sont touchés par différents types de problèmes sensoriels. Les anomalies d’intégration sensorielle proviennent du fait que les informations périphériques, que ce soit du touché, de l’ouïe, de la vision, ou d’autres stimuli, ne sont pas intégrées ou organisées correctement dans le cerveau, conduisant à un comportement inapproprié. De telles anomalies peuvent être extrêmement handicapantes au quotidien pour les personnes atteintes d’autisme et elles posent un défi aux parents et éducateurs. Par exemple, lors d’une sortie au supermarché, de simples lumières fluorescentes peuvent être une expérience sensorielle aversive. Malheureusement, les altérations de l’intégration sensorielle dans ces maladies et leurs traitements pharmacologiques sont peu étudiées, et ceci alors même que ces altérations sont également fréquemment observées dans une maladie neuro-développementale apparentée, à savoir le Syndrome de l’X Fragile.

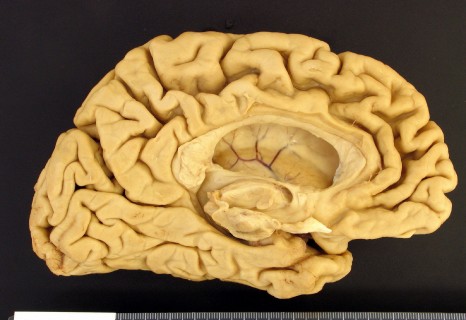

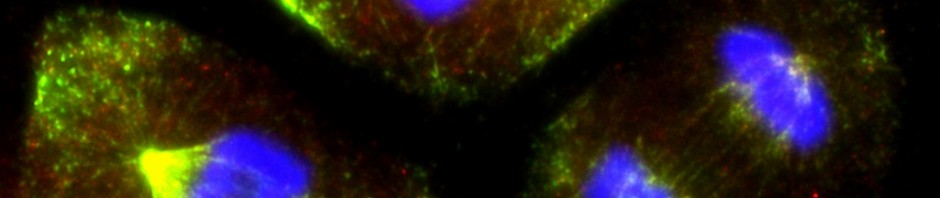

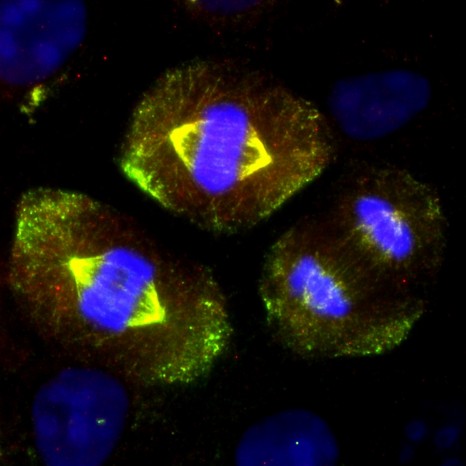

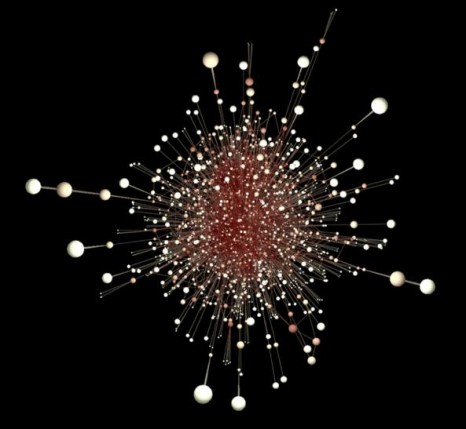

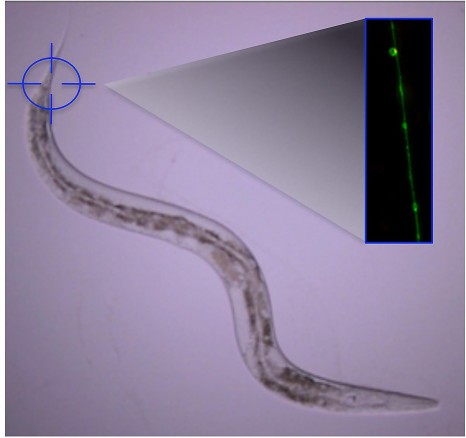

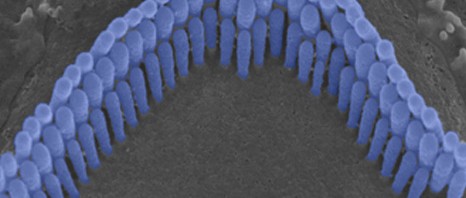

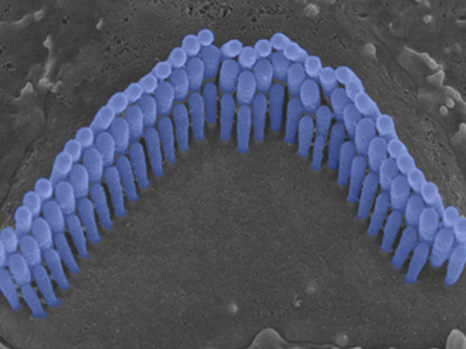

Dans une étude publiée dans Nature Neuroscience, des chercheurs de l’Inserm (en collaboration avec des chercheurs du CNRS) ont montré que des souris Fragile X présentent des anomalies dans la façon dont les informations sensorielles sont traitées par le néocortex, qui est la partie du cerveau responsable entre autres de la perception sensorielle. Les chercheurs ont montré que le néocortex de ces souris est hyper-excité en réponse à des stimulations sensorielles tactiles. Ils ont ensuite effectué une variété de tests détaillés montrant que cette hyperexcitabilité néocorticale est reliée à la façon dont les neurones de cette région du cerveau intègrent les informations sensorielles. Avec cette étude, les chercheurs ont trouvé que la fonction de certains canaux ioniques (les molécules qui déterminent la façon dont les neurones traitent les signaux électriques) est altérée dans le compartiment dendritique (la structure qui intègre les informations et qui se comporte véritablement comme le « cerveau » des neurones).