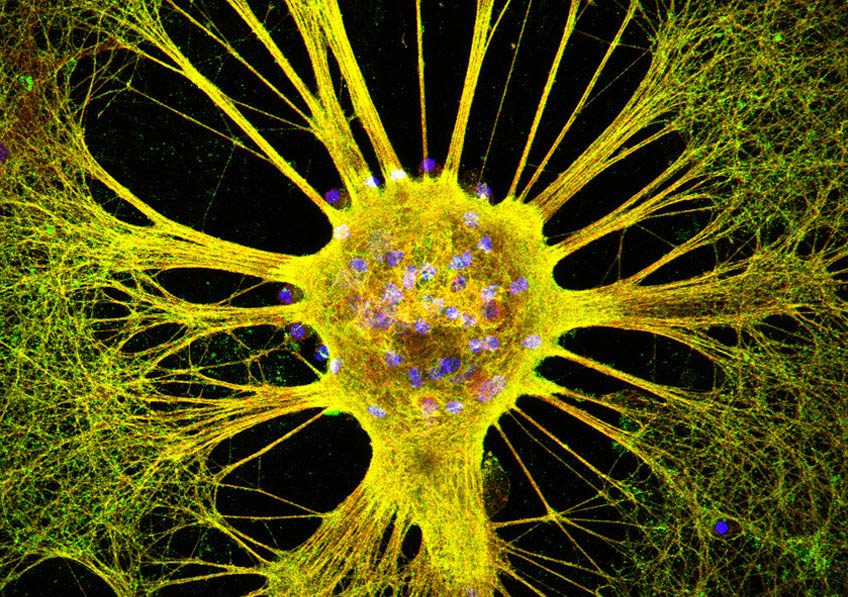

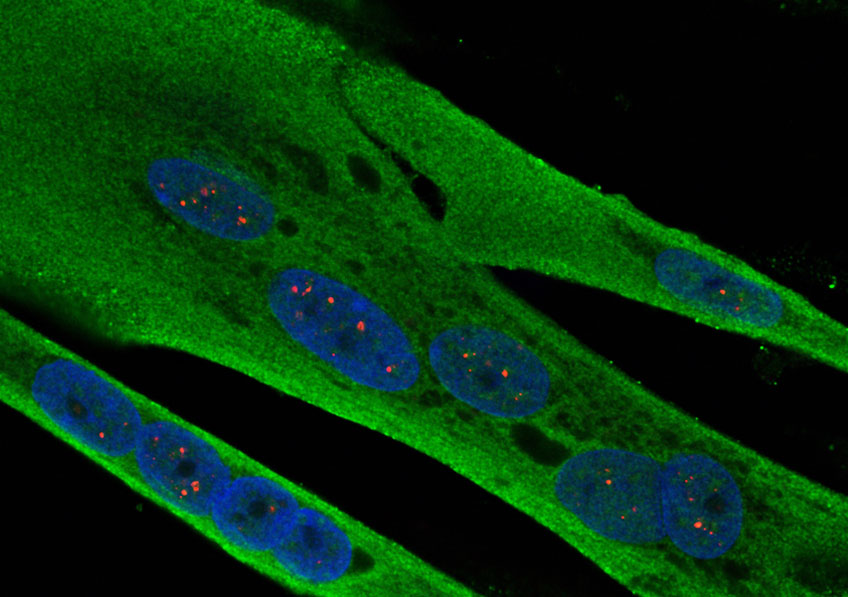

Cellules musculaire de patient atteint de dystrophie myotonique. Crédits: Inserm/IGBMC

Des chercheurs Inserm au sein d’I-Stem, l’Institut des cellules souches pour le traitement et l’étude des maladies monogéniques, annoncent des résultats encourageants de la metformine, un antidiabétique connu, pour le traitement symptomatique de la dystrophie myotonique de Steinert. En effet, un essai de phase II réalisé chez 40 malades, à l’hôpital Henri-Mondor AP-HP, montre que, après 48 semaines de traitement à la plus forte dose, les patients traités avec la metformine (contre placebo) gagnent en motricité et retrouvent une démarche plus stable. Les résultats de cet essai, financé à hauteur d’1,5 million d’euros par l’AFM-Téléthon, sont publiés ce jour dans la revue Brain.

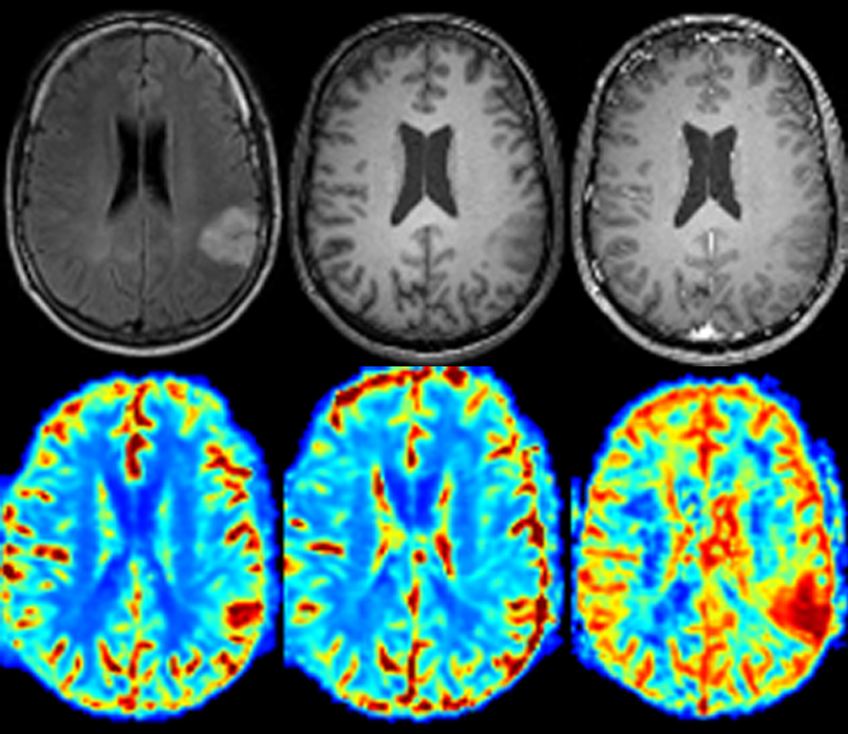

La dystrophie myotonique de Steinert (DM1) est la plus fréquente des dystrophies musculaires de l’adulte. D’origine génétique, sa prévalence est estimée à 1/8.000, soit environ 7 à 8000 malades en France. Elle affecte les muscles, qui s’affaiblissent (dystrophie) et ont du mal à se relâcher après contraction (myotonie) ce qui désorganise les mouvements (marche instable par exemple). Elle atteint également d’autres organes (cœur et appareil respiratoire, appareil digestif, système endocrinien et système nerveux). A ce jour, cette dystrophie musculaire ne bénéficie d’aucun traitement curatif.

Les résultats publiés dans Brain sont le fruit d’une recherche menée depuis plusieurs années au sein d’I-Stem. En effet, grâce au développement de modèles cellulaires à partir de cellules souches pluripotentes, l’équipe de Cécile Martinat a, en 2011, identifié des mécanismes nouveaux à l’origine de la dystrophie myotonique de Steinert (Cell Stem Cell – 31 mars 2011). En 2015, Sandrine Baghdoyan, ingénieure de recherche à I-Stem, parvient à corriger certains défauts d’épissage dans des cellules souches embryonnaires et dans des myoblastes provenant de personnes atteintes de DM1 grâce à la metformine, une molécule anti-diabétique bien connue et identifiée comme efficace dans cette nouvelle indication grâce au criblage à haut-débit.(Mol.Therapy – 3 nov 2015).

Forts de ces résultats, I-Stem a lancé un essai clinique monocentrique de phase II, en double aveugle, randomisé contrôlé, chez 40 patients, en collaboration avec des équipes de l’Hôpital Henri Mondor AP-HP, celle du Dr Guillaume Bassez du centre de référence maladies neuromusculaires Ile-de-France, et celle du Centre d’Investigation Clinique coordonné par le Pr Philippe Le Corvoisier. Dans cette étude contre placebo, la metformine a été administrée trois fois par jour, par voie orale, avec une période d’augmentation de la dose sur 4 semaines (jusqu’à 3 g/jour), suivie de 48 semaines à la dose maximale.