©AdobeStock

La consommation excessive d’alcool est associée à un triplement du risque de démences en général et un doublement de celui de développer la maladie d’Alzheimer, ce qui en ferait un facteur de risque modifiable majeur pour ces maladies. Telle est la conclusion d’une étude de l’Inserm menée en collaboration avec des chercheurs canadiens via le groupe de recherche QalyDays[1]. A partir de données exhaustives des hospitalisations en France entre 2008-2013, les chercheurs ont étudié l’association entre alcoolisme et démences. Leurs travaux parus dans The Lancet Public Health confirment l’importance de renforcer la prévention contre l’abus d’alcool.

La liste des troubles associés à l’alcool s’allonge encore. Après les problèmes hépatiques, cardiovasculaires et les cancers, les démences font maintenant partie du lot. Une consommation excessive d’alcool correspondant à six verres ou plus par jour pour les hommes et quatre pour les femmes s’est en effet trouvée associée à un triplement du risque de démences. Celles-ci incluent les démences précoces enregistrées avant 65 ans et directement attribuables à l’alcool de type syndrome de korsakoff, les démences vasculaires résultant par exemple d’accidents vasculaires cérébraux et enfin, les démences neurodégénératives de type Alzheimer.

Alors que quelques études suggèrent un effet protecteur d’une consommation faible à modérée d’alcool sur la fonction cognitive, peu de données permettent de travailler sur des consommations élevées. Les personnes alcooliques refusent en effet, dans la plupart des cas, de participer à des cohortes de recherche médicale. Pour contourner ce problème, les chercheurs ont utilisé les informations issues du Programme de Médicalisation des Systèmes d’Information qui renseigne toutes les causes d’hospitalisation. A partir de cette base, ils ont identifié 31,6 millions d’adultes hospitalisés entre 2008 et 2013 dont 1,3 million étaient affectés de démences et 950 000 présentaient une consommation excessive d’alcool (dont 85% une dépendance). Après exclusion des cas de démences attribuables à une pathologie bien identifiée, les chercheurs ont retrouvé une consommation excessive d’alcool dans 57% des démences précoces et 8% de celles survenues après 65 ans. Alors que pour l’ensemble des adultes hospitalisés, les taux d’alcoolisme étaient évalués à 6,2% chez les hommes et 1,5% chez les femmes.

Selon l’analyse de cette cohorte, la consommation excessive d’alcool est associée à un triplement du risque de démence et un doublement du risque en ce qui concerne la maladie d’Alzheimer. Après avoir pris en compte les autres facteurs de risque de démence, les chercheurs estiment qu’il s’agit d’un facteur de risque de démence (modifiable) , pouvant être considéré comme le plus important devant le tabagisme ou l’hypertension artérielle.

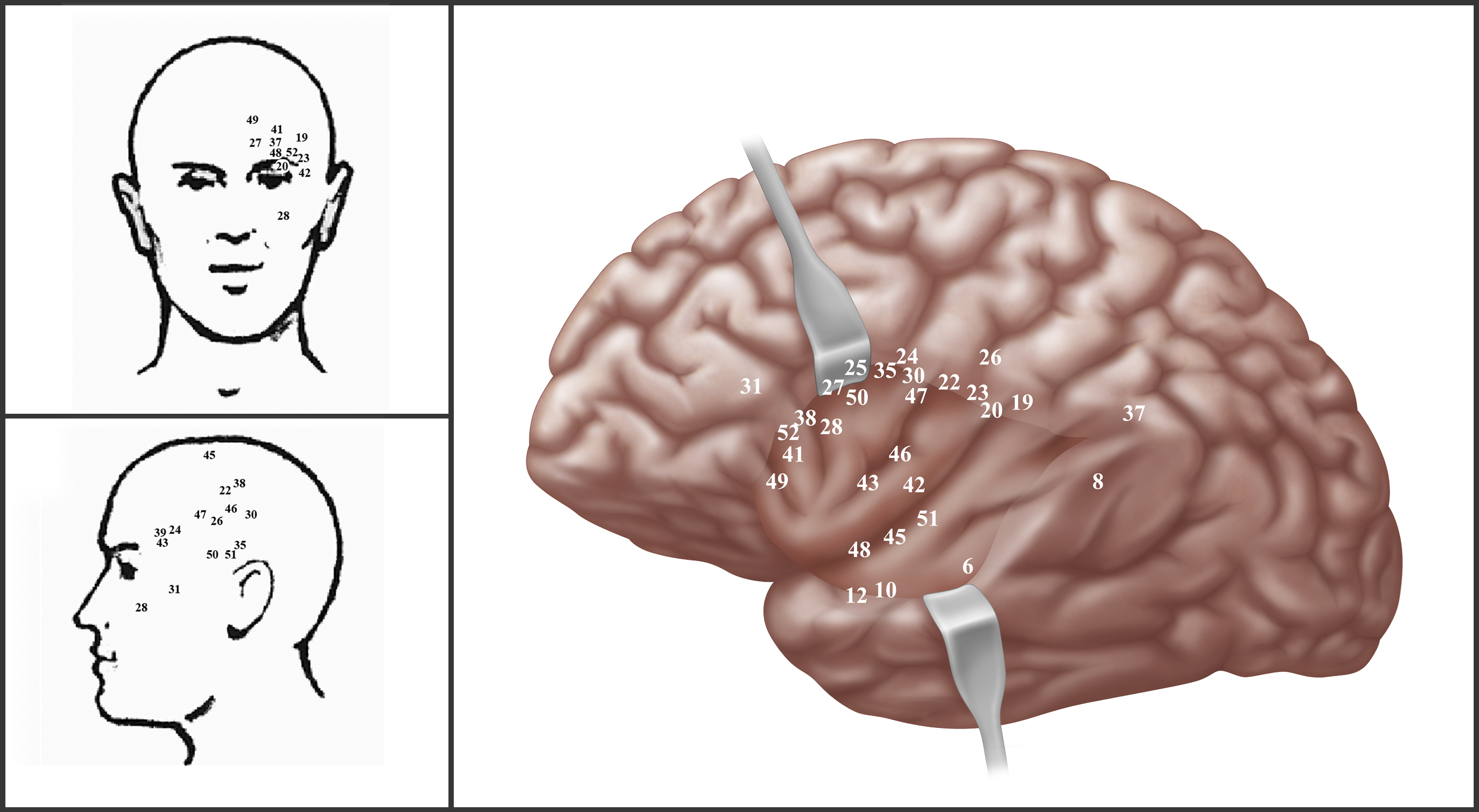

« Nous pensons que l’alcool pourrait précipiter la survenue de ces maladies et accélérer leur progression en augmentant les dommages structurels et fonctionnels dans le cerveau, expliquent les auteurs de ce travail Carole Dufouil, directrice de recherche à l’Inserm et Michaël Schwarzinger (Translational Health Economics Network (THEN) et chercheur affilié à l’Unité Inserm 1137 IAME « infection, antimicrobiens, modélisation, évolution »). Mais les mécanismes possibles sont nombreux et restent à clarifier. Cette étude interpelle donc une nouvelle fois sur les dangers de l’alcool, suggérant que des mesures préventives supplémentaires pourraient contribuer à réduire le risque de démences et leur coût financier et sociétal », clarifie Carole Dufouil.

Ces travaux permettent par ailleurs de confirmer l’intérêt de travailler avec des bases de santé. « Le fait de mettre en évidence un problème de santé majeur grâce à l’utilisation de ce type de données est très prometteur en raison de l’ouverture de ces bases dans le cadre de la loi de modernisation du système de santé », se réjouit Carole Dufouil. Les chercheurs ont désormais accès au « système national des données de santé » qui regroupe plusieurs bases de santé[2] « Les données utilisées dans notre étude sont imparfaites puisqu’elles n’ont pas été collectées spécifiquement pour nos travaux. Elles ne permettent pas par exemple, d’avoir une mesure précise de la consommation d’alcool, ni du seuil au-delà duquel le risque de démence devient élevé. Mais le nombre de cas est si important que la puissance statistique gomme beaucoup de ces imperfections. C’est le gros avantage de travailler à partir de ces bases », concluent Michaël Schwarzinger et Carole Dufouil.

[1] Le groupe QalyDays étudie les déterminants de l’espérance de vie et de l’espérance de vie sans dépendance. Il associe deux équipes Inserm au sein des unités mixtes 1137 « IAME « infection, antimicrobiens, modélisation, évolution » (Inserm-Université Paris Diderot) et 1219 « Bordeaux population health research center » (Inserm-Université de Bordeaux).

[2] (Données SNIIRAM de l’assurance maladie, base PMSI sur l’activité des établissements de santé, base CepiDC sur les causes de décès ou encore données liées au handicap, etc.).