Chaque année en France, 140 000 personnes sont victimes d’un accident vasculaire cérébral. © Adobe Stock

Chaque année en France, 140 000 personnes sont victimes d’un accident vasculaire cérébral (AVC)[1]. Environ 80 % d’entre eux sont des infarctus cérébraux ou AVC ischémiques, liés à l’occlusion d’une artère cérébrale par un caillot sanguin. Des études ont montré que le risque d’AVC ischémique était augmenté par la prise d’antipsychotiques, médicaments aux propriétés antidopaminergiques[2] communément prescrits en psychiatrie. Des chercheurs et chercheuses de l’Inserm et de l’université de Bordeaux (Centre de recherche Bordeaux Population Health), et du CHU de Bordeaux, ont évalué le risque d’AVC ischémique associé à l’exposition à d’autres médicaments antidopaminergiques : les antiémétiques, des médicaments utilisés de façon très courante dans le traitement symptomatique des nausées et vomissements. Les résultats de cette étude, obtenus grâce à l’analyse des données nationales de remboursement de soins de l’Assurance Maladie, mettent en évidence une association entre la prise de ces médicaments et le risque de présenter un AVC ischémique. Ils sont publiés dans le British Medical Journal.

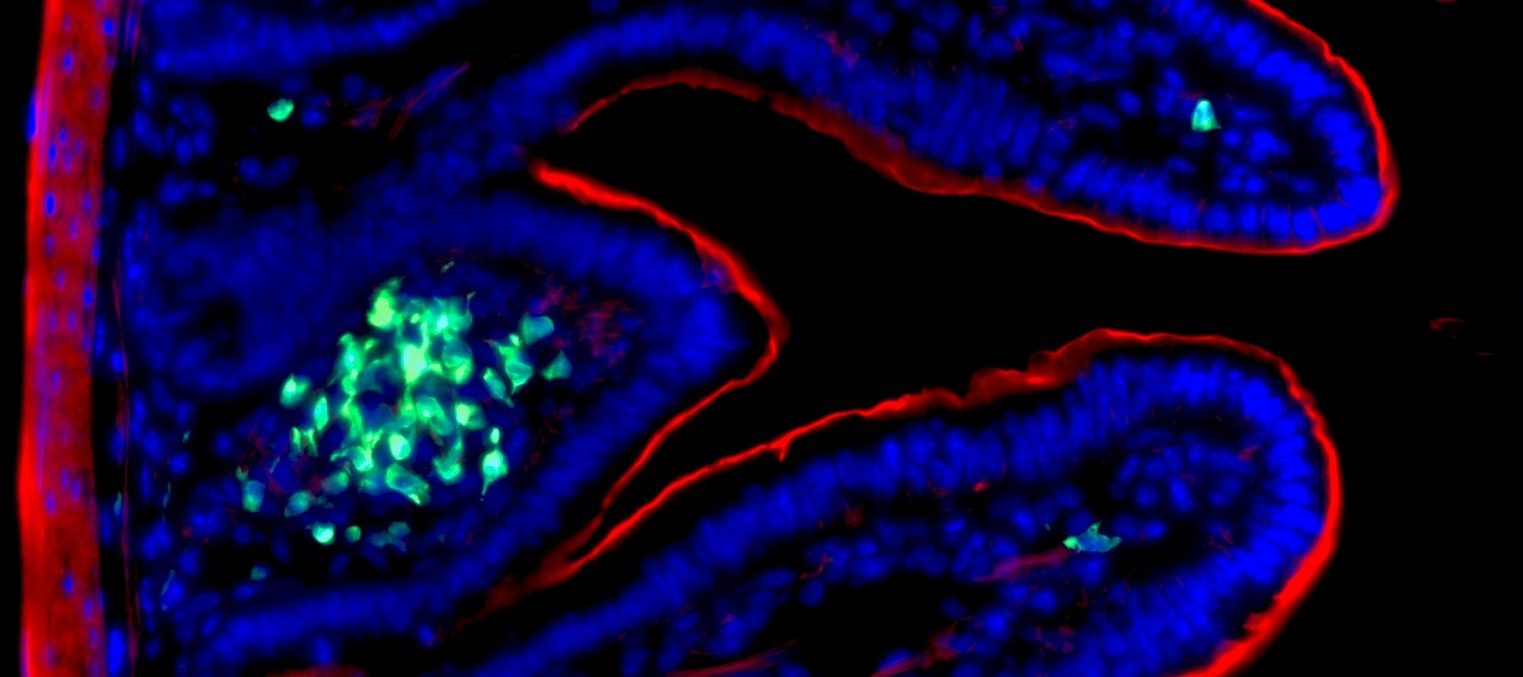

Depuis le début des années 2000, la prise des médicaments antipsychotiques indiqués en psychiatrie a été associée à un risque augmenté d’AVC ischémique. Ce risque a été démontré pour l’ensemble de ces médicaments à propriétés antidopaminergiques ; il augmente avec l’âge et l’existence d’une démence. Les mécanismes sous-jacents ne sont pas élucidés, l’action antidopaminergique est une hypothèse possible. Les antiémétiques -dompéridone, métoclopramide et métopimazine- utilisés dans le traitement symptomatique des nausées et vomissements d’origines diverses (gastro-entérite aigüe, migraine, contexte post-opératoire ou dans le cadre d’une chimio- ou radiothérapie) sont d’autres médicaments présentant cette propriété.

A ce jour, aucune étude n’avait été publiée évaluant le risque d’AVC ischémique associé à une exposition aux antiémétiques antidopaminergiques. Ces médicaments sont pourtant utilisés de façon très courante : en 2017 en France, plus de 4 millions de personnes avaient eu au moins un remboursement de métopimazine, le plus utilisé d’entre eux.

Des chercheurs et chercheuses de l’Inserm, de l’université de Bordeaux et du CHU de Bordeaux se sont intéressés à ce risque. Ils ont réalisé une étude[3] dite « cas propre-témoin » en utilisant les données de remboursement de l’Assurance Maladie et celles des admissions à l’hôpital. Dans ce type d’étude, l’utilisation potentielle du médicament dans la période précédant immédiatement l’accident (ici 14 jours) est comparée à la même utilisation au cours d’une période plus ancienne (ici plus d’un mois) où elle ne peut avoir provoqué l’événement. Une utilisation plus forte dans la période précédant immédiatement l’accident est en faveur d’un rôle joué par le médicament dans l’attaque.

Cette méthode permet de prendre en compte automatiquement les facteurs de risque personnels d’AVC ischémique, tels que le tabagisme, l’indice de masse corporelle, l’activité physique, ou les habitudes alimentaires. D’autres facteurs susceptibles de varier dans le temps court du suivi chez un même individu ont été considérés parmi lesquels l’utilisation de médicaments facteurs de risque d’AVC (tels que les vasoconstricteurs) ou au contraire prémunissant contre ce risque (anticoagulants, antiagrégants plaquettaires).

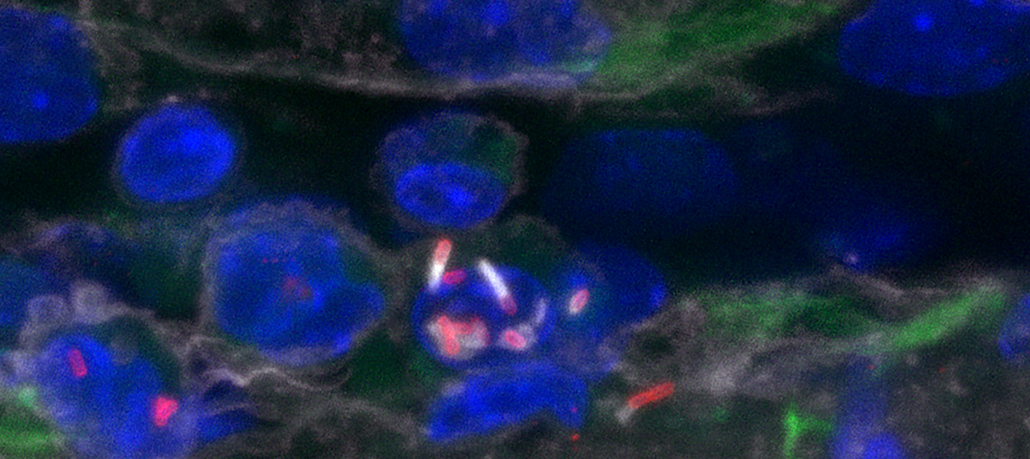

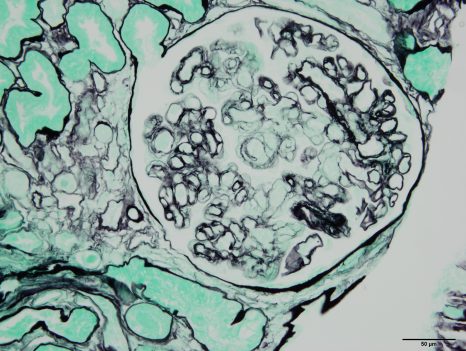

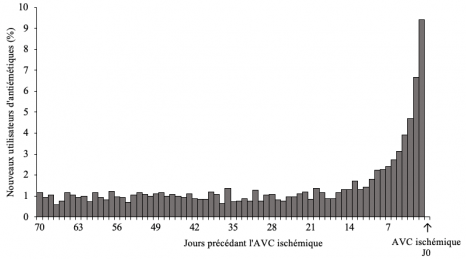

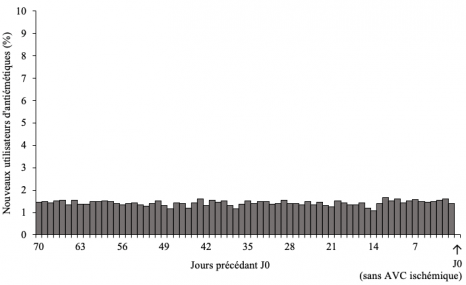

L’étude a ainsi dans un premier temps analysé les données pour 2 612 adultes hospitalisés pour un premier AVC ischémique et ayant débuté un traitement par antiémétiques dans les 70 jours précédant l’AVC ischémique. Chez ces sujets, les analyses ont retrouvé une plus forte consommation d’antiémétiques dans les jours précédant l’AVC marquée par un pic de d’initiation de traitement sur cette période. Ce résultat suggère qu’il y aurait une augmentation du risque d’AVC ischémique en début d’utilisation de ces médicaments (Figure ci-dessous).

Distribution de l’initiation des antiémétiques au cours des 70 jours ayant précédé la survenue de l’AVC ischémique (N=2 612 sujets avec AVC ischémique).

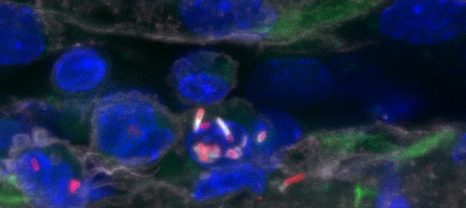

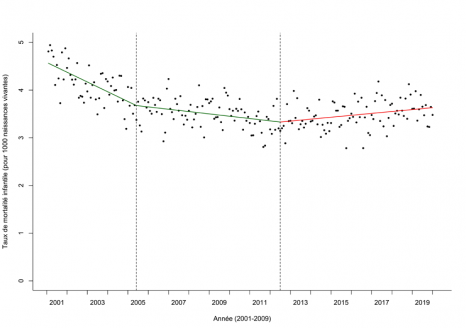

Pour éliminer un biais dans les résultats qui pourrait survenir si l’utilisation du médicament variait fortement au cours du temps dans la population générale (par exemple, lors d’épidémies de gastro-entérite aiguë), l’étude a dans un second temps considéré, sur la même période, un groupe aléatoirement constitué de 21 859 personnes n’ayant pas présenté d’AVC. Chez ces personnes, aucun pic ou excès d’utilisation d’antiémétiques comparable à celui mis en évidence chez les patients ayant présenté un AVC n’a été retrouvé (Figure ci-dessous).

Distribution de l’initiation des antiémétiques au cours des 70 jours précédant la date de référence (N= 21 859 sujets n’ayant pas présenté d’AVC ischémique).

Les résultats de cette étude suggèrent une augmentation du risque d’AVC ischémique dans les premiers jours d’utilisation des médicaments antiémétiques antidopaminergiques. Cette augmentation de risque était retrouvée pour les trois antiémétiques étudiés -dompéridone, métoclopramide et métopimazine-, et le risque apparaissait plus élevé dans les premiers jours d’utilisation.

« Cette première étude apporte un signal fort, portant sur des médicaments largement utilisés dans la population générale. Dans l’immédiat, il parait très important que ces résultats puissent être répliqués dans d’autres études, études qui pourraient en outre apporter des indications sur la fréquence de cet effet indésirable, que nous ne pouvions pas mesurer ici compte tenu de l’approche méthodologique retenue. Disposer d’informations précises sur les sous-types d’AVC ischémiques et leur localisation permettrait également d’explorer les mécanismes en cause », explique Anne Bénard-Laribière, l’une des auteurs de l’étude.

[1] Accident vasculaire cérébral (AVC), La première cause de handicap acquis de l’adulte, Inserm, 2019

[2] Les antidopaminergiques bloquent l’action de la dopamine, un neurotransmetteur impliqué, entre autres, dans la régulation du comportement, mais aussi du tonus musculaire et la coordination des mouvements.

[3] Cette étude a été réalisée dans le cadre du programme de travail du Centre DRUGS-SAFER, financé par l’ANSM et partenaire du GIS EPI-PHARE.