Streptococcus pneumoniae © Adobe Stock

Après une greffe de moelle osseuse, les patients atteints d’un déficit immunitaire sévère retrouvent leurs défenses immunitaires et peuvent reprendre une vie normale. Cependant, en regardant ce qui se passe au niveau de la sphère nasopharyngée, là où se met en place la première ligne de défense immunitaire, des chercheurs de l’Institut Pasteur, d’Université Paris Cité, de l’Inserm, de l’AP-HP et en collaboration avec l’Institut Imagine, ont mis en évidence une défaillance des mécanismes immunitaires chez certains de ces patients. Les résultats de cette étude, publiés dans le journal Blood le 14 février 2022, pourraient aider à leur proposer un traitement plus adapté.

Chez les patients atteints de déficit immunitaire combiné sévère1, le système immunitaire est défaillant et ne peut aider à lutter contre les multiples attaques microbiennes provenant de notre environnement. Alain Fischer, membre fondateur de l’institut Imagine situé à l’hôpital Necker-Enfants malades AP-HP, connaît bien ces patients, qu’il suit depuis plus de 30 ans. « Pour soigner ces personnes, il faut réaliser une allogreffe2 de moelle osseuse avec parfois une chimiothérapie pré-greffe pour éviter le rejet du greffon, résume le médecin et immunologiste. Ce procédé permet de guérir les patients, de restaurer leur système immunitaire, mais nous n’avions jamais étudié en détail ce qui se passait au niveau des muqueuses nasales. » En effet, la machinerie de la réponse immunitaire est d’une très grande complexité et fait intervenir un grand nombre d’acteurs : les acteurs de la réponse immunitaire innée, qui agissent au niveau des muqueuses de l’intestin, des poumons et du nez notamment, et ceux de la réponse adaptative, circulant dans le sang et la lymphe.

Afin de mieux comprendre la façon dont le système immunitaire inné était régulé, James Di Santo, responsable de l’unité Immunité innée (Institut Pasteur/Inserm), a proposé de comparer le système immunitaire des patients immunodéprimés après greffe avec ceux des patients sains de la cohorte Milieu Intérieur3. « Nous avions déjà récupéré, grâce à un simple écouvillon nasal, des échantillons nasopharyngés chez quelques 1 000 sujets et pu étudier la réponse immune grâce à eux, explique le chercheur. L’idée était de réaliser le même type de prélèvements chez les patients immunodéficients, couplé à une prise de sang, pour observer les différences ».

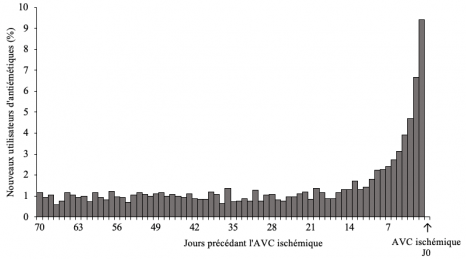

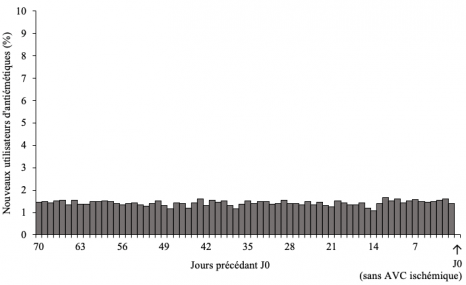

Très rapidement, les chercheurs ont pu observer des différences notables chez certains patients. Tandis que chez les sujets sains et la majorité des patients immunodéprimés, toute la sphère nasopharyngée se met habituellement en ordre de bataille face aux agressions avec formation de mucus protecteur, production en grande quantité d’anticorps (surtout d’IgA), de cellules immunitaires et maintien du microbiote, la muqueuse nasale est perturbée chez un certain nombre de patients après greffe. En effet, chez les patients dont la déficience immunitaire est partielle, et pour lesquels la chimiothérapie pré-greffe a été limitée, la sphère nasopharyngée présente une moins grande quantité de mucus, moins d’anticorps IgA et de cytokines4 et une prédominance des bactéries pathogènes.

En d’autres termes, ces personnes ont un système immunitaire mucosal moins actif face aux attaques quotidiennes des pathogènes. Par ailleurs, leur prise de sang révèle une déficience sélective de certaines cellules immunitaires circulantes.

« On sait que les cellules immunitaires du sang produisent des cytokines qui vont stimuler la production des anticorps, qui eux-mêmes sont chargés de neutraliser les bactéries pathogènes. Lorsque les cellules immunitaires du sang sont absentes, c’est une véritable réaction en chaîne qui s’opère et entraîne, au final, un déséquilibre du microbiote que l’on appelle une dysbiose », relate James Di Santo. Pour la première fois, les chercheurs ont donc pu observer, chez l’Homme, les mécanismes de l’immunité innée en action au niveau de la muqueuse nasale. Cette découverte pourrait par ailleurs conduire les médecins à ajuster leur protocole de greffe. « Les patients dont la capacité à produire des anticorps IgA n’est pas restaurée sont potentiellement plus vulnérables face aux infections respiratoires, explique Alain Fischer. On peut compenser cela par un traitement substitutif en anticorps, mais les résultats de cette nouvelle étude incitent également à recourir plus systématiquement à une chimiothérapie pré-greffe pour permettre une reconstitution complète de leur immunité. »

(1) Tous les déficits immunitaires combiné sévère ou DICS n’ont pas n’a pas la même origine génétique, ni le même profil immunologique. Les DICS sont des maladies très rares : la forme la plus fréquente ne concerne qu’une naissance sur 200 000 environ chaque année.

(2) Greffe provenant de quelqu’un d’autre.

(3) Milieu Intérieur (LabeX) Lluis Quintana-Murci – Darragh Duffy – Milieu Intérieur [LabEx] – Research – Institut Pasteur

(4) Messagers solubles qui assurent les communications entre les cellules du système immunitaire.